Leistungsstarke GPU-Server für KI-Anwendungen und lokales Hosting von LLMs

AI & LLM Server

DSGVO-konform Hosting in Deutschland NVIDIA RTX GPUs

AI Server mit  RTX™ GPU

RTX™ GPU

Maßgeschneiderte KI-Infrastruktur für das Handwerk, Unternehmen, Behörden und Forschung: Von der Workstation bis zum GPU-Cluster. Volle Datenkontrolle, maximale Leistung, individuelle Beratung.

Unsere Managed AI Server bieten Ihnen die perfekte Infrastruktur für das Hosting von KI-Modellen und LLMs in Ihrer eigenen Umgebung.

Mit unseren leistungsstarken GPU-Servern können Sie rechenintensive KI-Anwendungen betreiben und behalten gleichzeitig die volle Kontrolle über Ihre Daten. Unsere Managed AI Server sind vollständig konfiguriert und optimiert für maximale Performance und Zuverlässigkeit.

Lösungen für jede Unternehmensgröße

UPBITS liefert leistungsstarke KI-Server, On-Premise-Lösungen und Private Cloud-Setups für Unternehmen, Handwerksbetriebe, Behörden und Forschung. Wir unterstützen Sie bei Auswahl, Installation und Betrieb von Hardware für Large Language Models (z.B. GPT-4, Llama 2, Mistral), Bild-/Video-KI (Stable Diffusion, Sora), Vektordatenbanken (Qdrant) und Automatisierung (n8n). Unser Team begleitet Sie von der Beratung bis zum laufenden Betrieb – individuell, DSGVO-konform und mit besonderem Fokus auf die Anforderungen des Handwerks.

Individuelle KI-Server & Cluster

Workstations, Racks und GPU-Cluster – passend für Ihre Anforderungen und Ihr Budget. Beratung, Konfiguration und Aufbau durch erfahrene Experten.

Integration & Support

Wir übernehmen Installation, Inbetriebnahme, Updates und Support. Optional: Anbindung an bestehende Systeme, individuelle Automatisierung und Custom Training.

On-Premise AI & Private Cloud

Volle Datenhoheit mit lokal betriebener KI-Infrastruktur oder Private-Cloud-Lösungen. Keine US-Cloud, keine Datenabflüsse – maximale Sicherheit und Compliance.

Ihre Vorteile mit UPBITS KI-Servern

Unsere Lösungen bieten Ihnen maximale Kontrolle, höchste Performance und

volle Flexibilität – von der Hardware bis zur individuellen KI-Integration.

Datenhoheit & DSGVO-Konformität

Alle Daten bleiben in Ihrer Infrastruktur. Keine Cloud-Abhängigkeit, keine versteckten Zugriffe – 100 % Compliance.

Skalierbarkeit & Flexibilität

Von der Einzel-Workstation bis zum GPU-Cluster: Unsere Systeme wachsen mit Ihren Anforderungen. Für Start-ups, Mittelstand und Enterprise.

Beratung & Rundum-Service

Sie erhalten persönliche Beratung, individuelle Hardware-Auswahl, Installation, Wartung und Support – alles aus einer Hand.

Open Web UI: Die intuitive

Oberfläche für Ihre KI-Server

OpenWebUI stellt eine intuitive Weboberfläche für Ollama bereit, die die Nutzung von KI-Modellen erheblich erleichtert.

Dank Funktionen wie Chat-Verlauf, Modellverwaltung und Vorlagen für Eingaben verbessern Sie Ihre Interaktionen mit den KI-Modellen.

- Chatverlauf & Gespräche

- Modellverwaltungsoberfläche

- Vorlagen & Beispiele für Eingaben

KI Server Konfiguration

Premium Hardware für höchste Performance

KI Server Basic

Perfekt für Inferenz und kleine bis mittlere Modelle

- NVIDIA RTX™ 4000 SFF Ada

- 306.8 TFLOPS

- 20 GB GDDR6 VRAM

- Installation & Konfiguration von KI-Modellen (optional)

- Ollama & Qdrant Setup & Konfiguration (optional)

- OpenWebUI Installation (optional)

- GPU-Optimierung für maximale Performance

- Priorisierter E-Mail-Support

KI Server Pro

Für große Modelle und Modell-Training

- NVIDIA RTX™ 6000 Ada

- 1457.0 TFLOPS

- 48 GB GDDR6 VRAM

- Installation & Konfiguration von KI-Modellen (optional)

- Ollama & Qdrant Setup & Konfiguration (optional)

- OpenWebUI Installation (optional)

- GPU-Optimierung für maximale Performance

- Priorisierter E-Mail-Support

- Modell-Training (Feinabstimmung)

Alle Pläne beinhalten

Monatlich kündbar DSGVO konform Serverstandort Deutschland ISO 27001 zertifiziertes Rechenzentrum

Unterstützte KI-Modelle

Getestet mit führenden Open-Source LLMs: Gemma, DeepSeek, Llama, Mistral, Qwen, Phi und vielen weiteren Modellen für verschiedenste Anwendungsfälle.

Llama 3.1

Neueste Modelle von Meta. Erhältlich in 8B, 70B und 405B. Hervorragende Unterstützung für Tools.

Meta Tools

Gemma 3

Das momentan stärkste Modell, das auf einer einzelnen GPU läuft. Vision-Unterstützung ist enthalten.

Open Source Google

DeepSeek-R1

Innovative Reasoning-Modelle, die in der Leistung mit O3 und Gemini 2.5 Pro mithalten. Unterstützung für Denkprozesse und Werkzeuge.

Reasoning Thinking

Ollama & vLLM

Ollama ermöglicht eine benutzerfreundliche Handhabung für zügiges Prototyping, während vLLM höchste Leistung für produktive Anwendungen bietet.

Auf Anfrage installieren und richten wir beide Systeme auf Ihrem Server ein, sodass Sie je nach Bedarf die passende Engine auswählen können (optional).

vLLM für maximale Performance

vLLM ist eine leistungsstarke Inferenz-Engine, die speziell für Umgebungen mit hohen Anforderungen an den Durchsatz konzipiert wurde.

Perfekt geeignet für APIs, Batch-Verarbeitung und Anwendungen mit zahlreichen gleichzeitigen Benutzern.

Phi-4

Kompaktes, effizientes Modell von Microsoft

Microsoft Efficient

Qwen

Multilinguale LLMs von Alibaba Cloud

Alibaba Multilingual

Mixtral

MoE-Architektur für effiziente Large Language Models

Mistral AI MoE

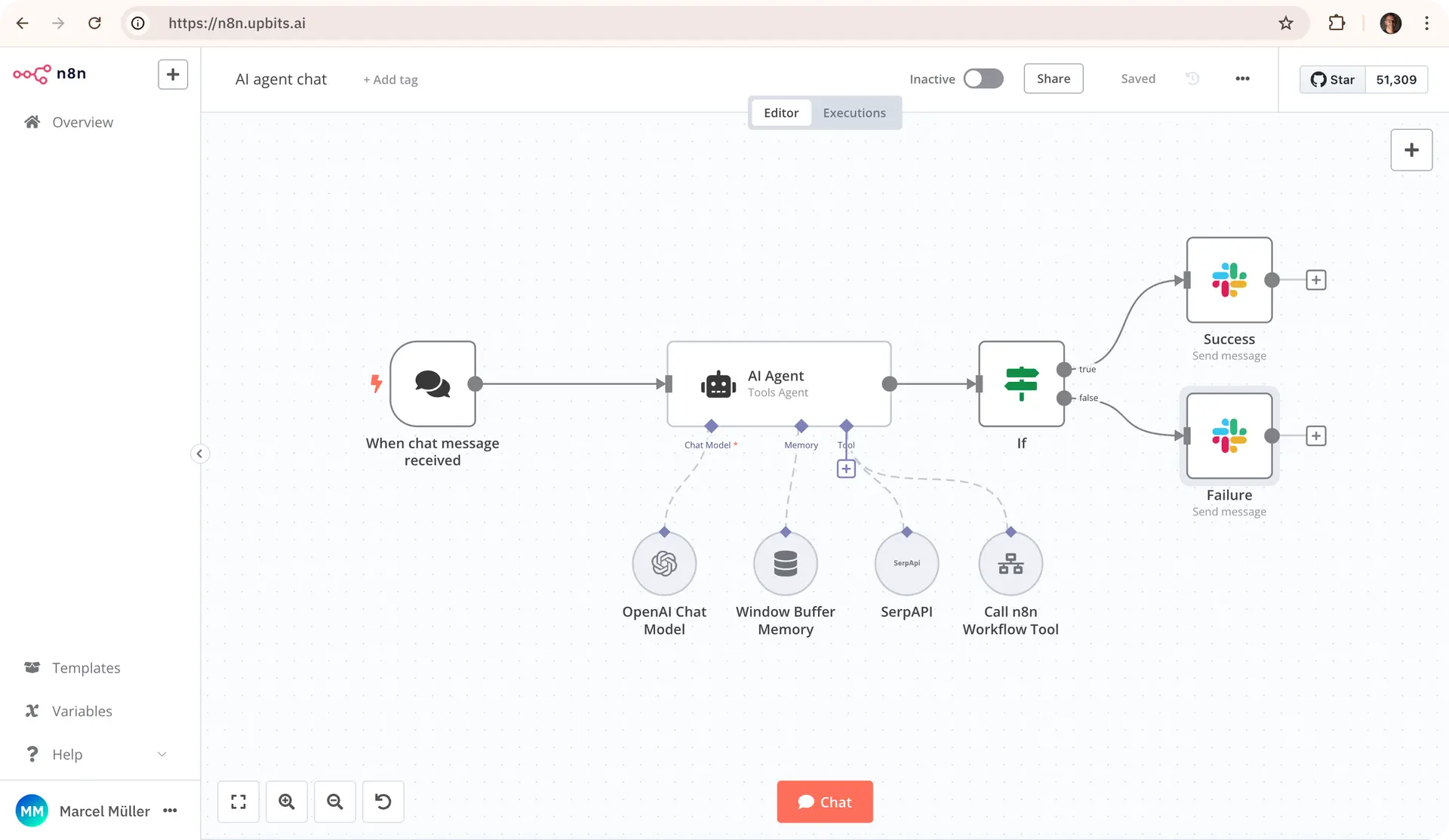

n8n Workflows

Mit n8n automatisieren Sie Ihre Unternehmensprozesse flexibel, sicher und vollständig unter eigener Kontrolle. Die Open-Source-Plattform lässt sich lokal oder in Ihrer Private Cloud betreiben und verbindet Ihren KI Hub mit E-Mail, DMS, Kanzleisoftware, Kalender und vielen weiteren Systemen.

So schaffen Sie effiziente Workflows – von der Mandantenaufnahme über die Dokumentenablage bis hin zu automatisierten Benachrichtigungen. Maximieren Sie Effizienz, minimieren Sie Fehler und behalten Sie die volle Datenhoheit – ohne Cloud-Zwang.

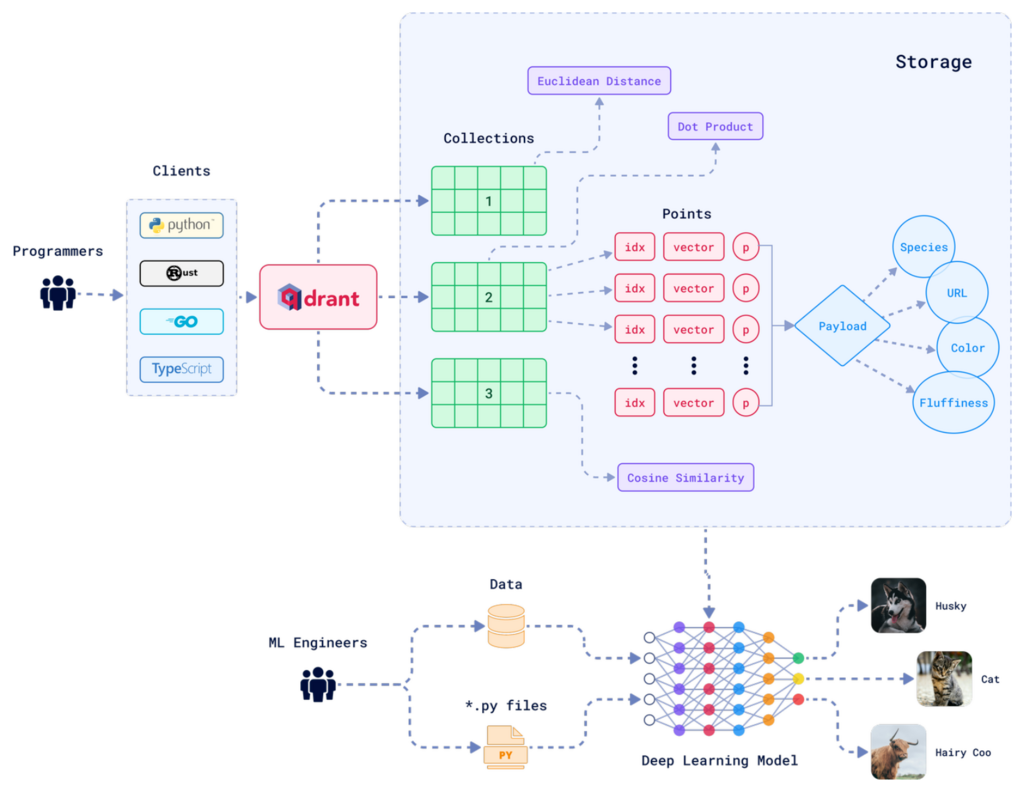

Qdrant Vektorspeicher Das Herzstück

für Ihr Unternehmenswissen

Qdrant ist Ihr zentraler Vektorspeicher für Unternehmenswissen. Die Open-Source-Datenbank speichert Dokumente, E-Mails und Handbücher als semantische Embeddings und macht sie für Ihre KI-Modelle sofort durchsuchbar.

Zusammen mit Open Web UI und n8n entsteht eine flexible, DSGVO-konforme Plattform, die Wissen sicher bereitstellt – für smarte Suche, Kontext und intelligente Assistenten. So nutzen Sie KI, ohne sensible Daten aus der Hand zu geben.

Unsere Mission: KI-Souveränität für Ihr

Unternehmen – ohne Cloud-Zwang, ohne Kompromisse.

Warum UPBITS KI-Server ?

Datenschutz & Kontrolle

Ihre Daten werden sicher in Deutschland aufbewahrt. Sie genießen die vollständige Kontrolle über alle Ihre KI-Modelle und die damit generierten Daten, sodass Sie jederzeit Transparenz und Sicherheit gewährleisten können.

Maximale Performance

Exklusiv zugewiesene GPU-Ressourcen, die nicht mit anderen Nutzern geteilt werden. Diese Konfiguration ist speziell darauf ausgelegt, um eine extrem niedrige Latenz und einen hohen Datendurchsatz zu gewährleisten, was sie ideal für anspruchsvolle Anwendungen macht.

Managed Service

Wir übernehmen für Sie die komplette Installation, regelmäßige Updates und die umfassende Wartung Ihrer Systeme, sodass Sie sich ganz auf die Nutzung und Optimierung Ihrer KI-Modelle konzentrieren können, ohne sich um technische Details kümmern zu müssen.

API-Zugriff

Vollumfänglicher Zugang zur API, der Ihnen ermöglicht, eine reibungslose Integration in Ihre Anwendungen und Arbeitsabläufe zu realisieren und so die Effizienz Ihrer Prozesse zu steigern.

Modell-Flexibilität

Greifen Sie auf eine Vielzahl von Open-Source-Modellen zurück, ohne sich um Anbieterbindungen oder Einschränkungen kümmern zu müssen. Ihre Flexibilität bleibt somit jederzeit gewährleistet.

Skalierbar

Beginnen Sie mit einer kleinen Lösung, die Ihren aktuellen Anforderungen entspricht, und wachsen Sie schrittweise, während sich Ihre Bedürfnisse weiterentwickeln. Ein Upgrade auf eine umfangreichere Version ist jederzeit problemlos möglich.

Lassen Sie uns über Ihre Idee sprechen

Sprechen Sie mit uns über Ihre Anforderungen – wir beraten Sie persönlich, unverbindlich und kompetent.

Gemeinsam finden wir die optimale KI-Lösung für Ihr Unternehmen.